Bienvenue sur mon blog.

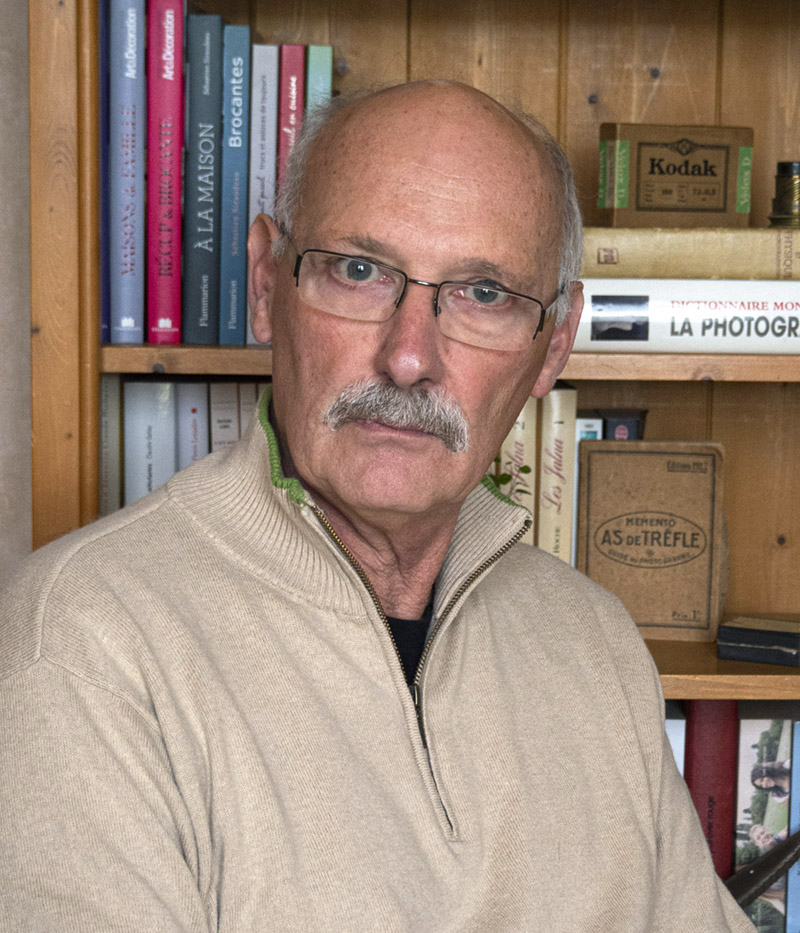

J’ai eu beaucoup de chance. De la cuvette de révélateur du club photo du lycée en 1965 à chef de projet dans la conception de logiciel de création d’album en 2010, j’ai pu évoluer dans ce métier à travers de multiples fonctions et vivre de cette passion.

A travers ce blog, j’ai voulu partager une grande partie de mon expérience professionnelle. J’espère que vous y trouverez quelques informations utiles.

Jean-Claude ROMON

En savoir plus sur mon parcours

Suivez moi sur Instagram

Voir mes réalisations sur My Portfolio

Note importante :

Comme vous devez le savoir, la technologie évolue très vite. Lors de la lecture, il est important que vous preniez en compte la date de la rédaction de la formation. Les premières ont été rédigées en 2017 et certains éléments peuvent être devenus obsolètes. La rédaction de ces formations prend toujours beaucoup de temps, je dois effectuer bon nombre de vérifications et de tests afin de garantir la fiabilité des écrits. De ce fait, je ne fais pas de mise à jour pour les faire évoluer techniquement.

Cinq formations pour bien

débuter en photographie